За кулисами Midjourney: Google опубликовала инструкцию по созданию идеальных text-to-image моделей

Google опубликовала исследование об эффективном обучении text-to-image моделей. Разбираем, как их «рецепты» помогут сэкономить миллионы и изменить AI-индустрию.

Пока Илон Маск обещает нам сверхразум в следующем квартале, а Сэм Альтман показывает голливудские трейлеры, сгенерированные Sora, в исследовательских лабораториях Google происходит настоящая, пусть и не такая громкая, работа. На днях они опубликовали статью, название которой усыпит любого маркетолога: «Training Design for Text-to-Image Models: Lessons from Ablations». Но за этой академической скукой скрывается, возможно, один из самых важных документов для индустрии генеративного ИИ за последнее время. Это не новый продукт, который можно потыкать. Это подробная поваренная книга, объясняющая, как «готовить» свои собственные Midjourney и DALL-E — только быстрее, дешевле и с предсказуемым результатом.

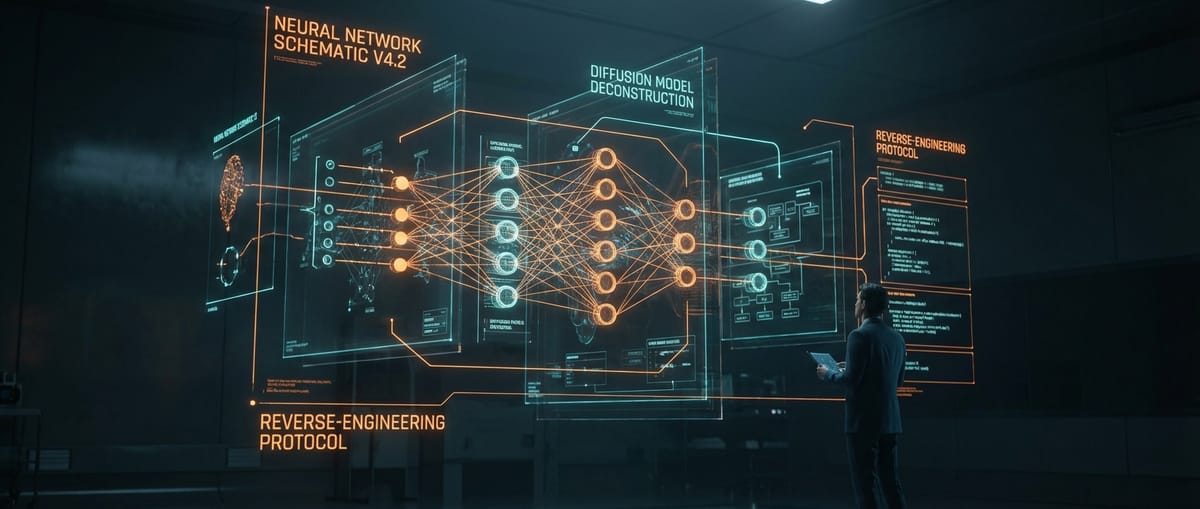

Суть работы проста, как все гениальное. Инженеры Google провели масштабное «абляционное исследование». Если по-человечески, они взяли стандартный процесс обучения text-to-image модели и начали методично его ломать: отключали по одному компоненту, меняли параметры, варьировали архитектуру, чтобы понять, что на самом деле влияет на итоговое качество картинки, а что — просто дорогостоящий карго-культ, который все повторяют друг за другом. Они проверили всё: от архитектуры U-Net и качества текстовых энкодеров до таких тонкостей, как расписание зашумления и методы классификации данных. Итог — набор четких рекомендаций, который может сэкономить разработчикам миллионы долларов и тысячи часов GPU-времени.

Давайте на секунду оторвемся от магии и поговорим о деньгах. Обучение одной большой диффузионной модели уровня Stable Diffusion 3 — это десятки миллионов долларов, вложенных в «железо» и электричество. Каждая неудачная экспериментальная сборка — это сотни тысяч, улетевшие в трубу, а точнее, в тепловые решетки дата-центров. Поэтому исследование Google — это не просто научный интерес. Это прямое руководство к действию для тысяч команд по всему миру, которые пытаются конкурировать с гигантами, не имея их бездонных карманов. Теперь им не нужно гадать, стоит ли вкладываться в более сложный текстовый энкодер или лучше потратить ресурсы на очистку датасета. Ответы уже есть, и они подкреплены сотнями тестов.

В этой публикации виден классический почерк Google в их вечной борьбе с OpenAI. Пока OpenAI строит закрытые, почти мистические продукты, окружая их ореолом тайны, Google играет вдолгую, делая ставку на открытую науку и экосистему. Публикуя подобные «рецепты», они не просто делятся знаниями. Они стимулируют всё сообщество, включая академические круги и опенсорс-разработчиков, двигаться вперед, используя их наработки. А где все эти разработчики будут обучать свои новые, более эффективные модели? Вероятно, на облачной платформе Google Cloud, используя их же TPU-ускорители. Красивый, многослойный ход, который приносит пользу всем, но в конечном счете — и самой корпорации.

Наш вердикт: это не маркетинговый пшик, а настоящий инфраструктурный сдвиг. Для конечного пользователя ничего не изменится прямо сейчас — новых кнопок «сделать красиво» не появится. Но эта работа — тот самый незаметный тектонический толчок, который через 6-12 месяцев породит целую волну новых, более качественных и доступных опенсорс-моделей. Google не дала нам рыбу, она раздала всем чертежи сверхэффективной удочки. И в мире, где «рыбалка» стоит миллионы, это куда более ценный подарок. Это тихая, но очень важная победа инженеров над маркетологами, и именно такие победы в итоге и двигают индустрию вперед, а не громкие анонсы на пресс-конференциях.