Правила для AI мертвы, да здравствуют границы

Анализ новой волны кибератак через AI-агентов от Google и Anthropic. Объясняем, почему инструкции в промпте бесполезны и как выстраивать защиту на уровне системных «границ».

Взломы через промпт-инъекции, когда-то бывшие забавой для энтузиастов, мутировали в полноценный вектор атак на корпоративную инфраструктуру. От гипотетического взлома Google Gemini для манипуляции календарями до использования кода Anthropic Claude в качестве движка для автоматизированных вторжений — мы вступаем в эру, где уязвимы не данные, а автономные рабочие процессы. Проблема больше не в том, ЧТО модель скажет, а в том, ЧТО она сделает по указке злоумышленника, получив доступ к вашим инструментам.

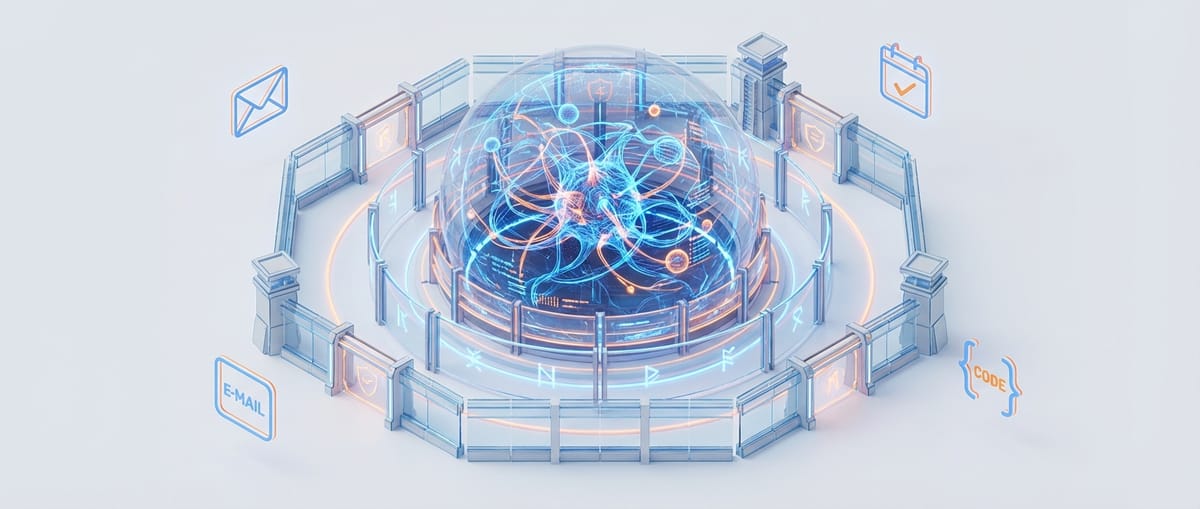

Техническая суть проблемы проста: правила, заложенные в системный промпт модели («ты полезный ассистент, не делай зла»), — это всего лишь рекомендации, которые обходятся парой трюков. Эффективная защита строится не на уровне промпта, а на уровне «границ» (boundaries) — набора инструментов и API, с которыми взаимодействует агент. Вместо того чтобы просить модель «не удалять важные файлы», нужно дать ей доступ к API, который в принципе не имеет функции удаления или требует многофакторного подтверждения от человека. Безопасность смещается от лингвистики к архитектуре систем.

Эта уязвимость — прямое следствие стратегической гонки между OpenAI, Google и Anthropic. Все они спешат превратить свои LLM из пассивных чат-ботов в проактивных «агентов», способных выполнять многошаговые задачи. Но чем больше у агента полномочий (доступ к API, файловой системе, внутренним сервисам), тем выше цена ошибки. Пока компании меряются размерами контекстных окон и скоростью генерации, тихая война уже разворачивается на поле безопасности агентных систем. Победит не тот, кто создаст самого умного агента, а тот, кто сделает его самым надежным и управляемым.