Кризис доверия в эпоху ИИ: почему мы боимся не того

Мы все боимся идеальных дипфейков, созданных ИИ. Но что, если настоящая проблема не в них, а в потоке «достаточно хорошего» контента, который разрушает наше доверие к реальности? Анализ кризиса доверия.

Нас годами пугали эпохой «распада истины». Тем самым мрачным будущим, где сгенерированный искусственным интеллектом контент водит нас за нос, формирует наши убеждения и заставляет сомневаться в собственных глазах. И вот, кажется, мы в нем. Новостные ленты пестрят то Папой Римским в пуховике Balenciaga, то арестом Трампа, которого не было. Все это — наглядные проделки нейросетей. И каждый раз, когда мы ловим очередной фейк, мы облегченно выдыхаем: «Ага, попался! Я умнее машины!» Но что, если мы смотрим не туда? Что, если главная угроза — не в том, что нас однажды идеально обманут, а в чем-то куда более коварном?

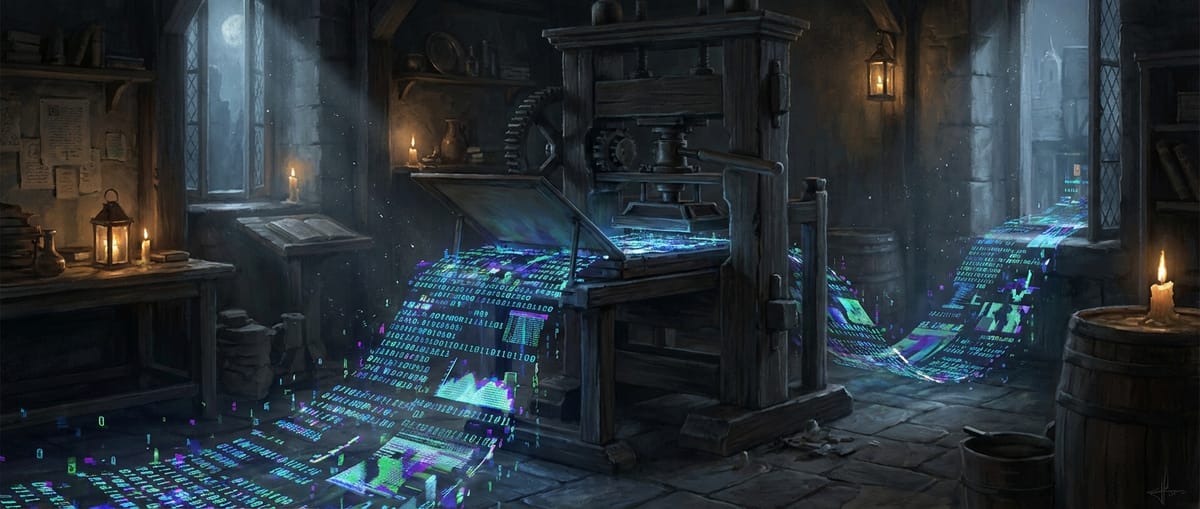

Давайте начистоту. Сегодняшние громкие дипфейки и картинки от Midjourney — это, по большей части, цифровой фастфуд. Яркий, вызывающий, но при ближайшем рассмотрении — грубо слепленный. Лишние пальцы, странные тени, неестественная физика. Большинство из нас уже научились считывать эти цифровые артефакты. Мы видим фейк, посмеиваемся и скроллим дальше, чувствуя себя проницательными борцами с дезинформацией. Технологические гиганты обещают нам водяные знаки и детекторы, которые будут отличать «зерна от плевел». Звучит как план, но в этой гонке вооружений атака всегда будет на шаг впереди защиты. И пока мы готовимся к битве с одним идеальным, неотличимым от реальности дипфейком, мы пропускаем армаду «достаточно хороших» подделок, которая уже штурмует наши головы.

И вот здесь-то мы и подходим к главной ошибке в нашем восприятии «кризиса истины». Проблема не в одном фейковом видео президента, которое изменит ход выборов. Проблема в тысячах сгенерированных статьях, которые на 80% состоят из правды, но содержат 20% ядовитой лжи. В миллионах комментариев под постами в соцсетях, написанных ботами для создания иллюзии общественного мнения. В бесконечном потоке контента, который не пытается вас обмануть раз и навсегда, а просто создает информационный шум, в котором тонет любой факт. Это как капающий кран: одна капля не страшна, но за год она способна разрушить камень.

Эта тактика «тысячи порезов» куда эффективнее одного нокаутирующего удара. Зачем тратить огромные ресурсы на создание идеального дипфейка, который разоблачат через пару часов? Гораздо дешевле и проще с помощью условного ChatGPT от OpenAI наштамповать сотни посредственных, но правдоподобных текстов, которые будут сеять сомнение, размывать границы факта и вымысла, и, что самое главное, вызывать у нас когнитивную усталость. Человеческий мозг — не процессор, он не может вечно работать в режиме тотальной проверки фактов. В какой-то момент он сдается и говорит: «Я не знаю, чему верить, поэтому не буду верить ничему».

И это — настоящая победа дезинформации. Цель не в том, чтобы мы поверили в ложь. Цель в том, чтобы мы перестали верить в правду. Когда любая фотография с места событий может быть «сгенерирована», любой документ — «подделкой», а любое экспертное мнение — «мнением чат-бота», рушится сама основа нашего общества — общее представление о реальности. Мы перестаем доверять институтам, медиа, науке и, в конечном счете, друг другу. Это не просто «распад истины», это атомизация общества, где каждый заперт в своем пузыре недоверия.

Наш вердикт: мы слишком увлеклись технологической стороной проблемы, ожидая появления цифрового Франкенштейна, который нас обманет. А настоящий монстр оказался куда прозаичнее. Это не идеальная ложь, а бесконечный поток посредственной полуправды, который истощает наше внимание и убивает способность к критическому мышлению. Поэтому и решение лежит не столько в плоскости создания идеальных детекторов фейков, сколько в старой, как мир, концепции медиаграмотности. Нам нужно не столько прокачивать машины для поиска лжи, сколько апгрейдить собственное «программное обеспечение» в голове. Учиться задавать вопросы, проверять источники и, что самое сложное в нашу эпоху, — допускать, что мы можем быть неправы. В противном случае мы проиграем эту войну не потому, что ИИ стал слишком умным, а потому, что мы сами разучились думать.