Как Swann и AWS научили 12 млн камер отличать курьера от грабителя и сократили расходы на AI в 350 раз

Кейс Swann: как генеративный AI на Amazon Bedrock помог обработать данные с 12 млн камер, повысить точность и сократить расходы с $2.1 млн до $6 тыс.

Каждый, кто хоть раз ставил себе умную камеру, знает эту боль. Уведомление! Тревога! Бежишь к телефону, а там — соседский кот в пятый раз за утро вальяжно пересекает твой газон. Или хуже — ветка качнулась. В итоге через неделю «умные» уведомления летят в мьют, а вместе с ними и потенциально реальные угрозы. Компания Swann, один из пионеров рынка DIY-видеонаблюдения, столкнулась с этой проблемой в масштабе 11.74 миллионов устройств. Их клиенты тонули в потоке из 20 бесполезных алертов в день с каждой камеры. Решение, которое они выкатили вместе с Amazon Web Services, — это не просто очередной маркетинговый кейс «мы внедрили AI», а настоящая дорожная карта по созданию рентабельного AI-продукта в мире железа.

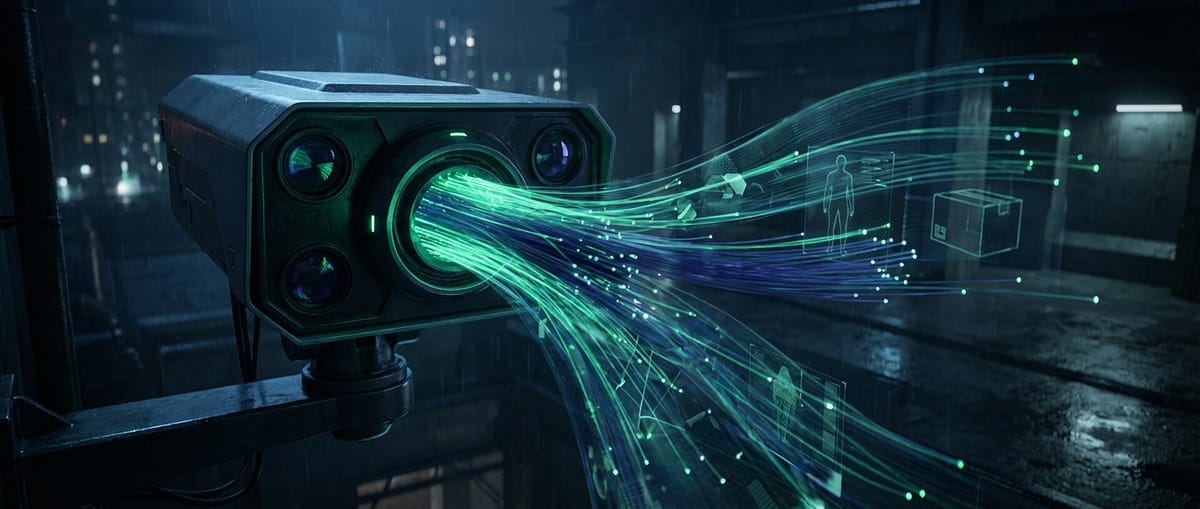

Суть проекта проста: научить камеры не просто детектировать движение, а понимать контекст происходящего. Отличать курьера с посылкой от подозрительного типа, который прощупывает дверной замок. Для этого Swann развернула систему на базе Amazon Bedrock — по сути, супермаркета толковых нейросетей с единым API. Но дьявол, как всегда, в деталях, а в мире AI — еще и в ценнике. Если бы Swann просто начала гонять каждый кадр через самую мощную модель вроде Claude Sonnet, их ежемесячный счет за облака взлетел бы до астрономических $2.1 миллиона. Вместо этого инженеры построили систему, которую можно описать как «умную бюрократию» для нейросетей.

Их архитектура — это многоуровневый фильтр. Сначала базовая логика и компьютерное зрение на сравнительно дешевых GPU-инстансах отсеивают 65% очевидного мусора: те самые качающиеся ветки и проезжающие машины. Это еще даже не GenAI, а старый добрый CV. И только оставшиеся, потенциально интересные кадры, отправляются на анализ в Bedrock. Но и там их встречает не одна модель, а целая иерархия. 87% оставшихся запросов обрабатывает самая быстрая и дешевая модель Nova Lite — ее задача провести экспресс-скрининг. Если она видит что-то подозрительное, эстафета передается модели поумнее — Nova Pro (8% запросов). И только для самых сложных и неоднозначных сценариев (3% случаев) в игру вступает тяжелая артиллерия в лице Claude Sonnet, способная на глубокий анализ поведения. Отдельно стоит Claude Haiku (2%), которая с минимальной задержкой обрабатывает кастомные запросы пользователей типа «сообщи, если ребенок подойдет к бассейну».

Но даже эта изящная схема не сработала бы без еще одного «скучного» элемента — промпт-инжиниринга. Инженеры Swann сократили объем передаваемых данных на 88%, сжав запросы со 150 до 18 токенов. Вместо пространных описаний — четкие, машинно-читаемые пары «ключ-значение» вроде `threat:LOW|type:person|action:delivery`. В итоге компания не просто внедрила модную технологию, а добилась впечатляющих бизнес-метрик: количество уведомлений снизилось на 25%, их релевантность выросла на 89%, а удовлетворенность клиентов — на 3%. Но главное — финальный счет за AI-инфраструктуру составил всего $6 тысяч в месяц. Падение на 99.7% или в 350 раз от первоначальных прогнозов.

Этот кейс — холодный душ для всех, кто думает, что внедрение генеративного AI — это просто подключение к API OpenAI или Google. Настоящая битва за рентабельность идет не на фронте создания моделей, а на поле грамотной инженерной архитектуры. AWS, предоставляя через Bedrock целый зоопарк моделей, подыгрывает этой тенденции, позиционируя себя не как создателя лучшего AI, а как лучшую «песочницу» для сборки сложных, многокомпонентных систем. Пока одни меряются количеством параметров в своих LLM, другие тихо строят бизнес, где AI — это не статья расходов, а инструмент, приносящий измеримую пользу при контролируемых затратах.

Наш вердикт: Это не прорыв в области искусственного интеллекта как такового. Модели Claude и Nova уже существовали. Это прорыв в области прикладной AI-инженерии и экономики. Swann и AWS показали, что магия GenAI кроется не в выборе самой «умной» модели, а в создании системы, которая использует ее только тогда, когда это абсолютно необходимо. 99% успеха этого проекта — это грамотная предварительная фильтрация, каскадная логика и оптимизация токенов. Это кейс о том, что в реальном мире побеждает не самый мощный, а самый эффективный. И это куда более ценный урок для рынка, чем очередные рекорды в бенчмарках.