Безопасный AI-ассистент — это миф? Разбираем феномен OpenClaw и его дыры в безопасности

Вирусный AI-помощник OpenClaw дает ИИ доступ ко всем вашим данным. Разбираем, почему это кошмар безопасности и что такое атаки через промпт-инъекции.

Мечта о персональном AI-ассистенте, который был бы умнее, быстрее и преданнее любого человека-помощника, витает в воздухе Кремниевой долины уже не первый год. Цифровой дворецкий, который разгребает почту, пока вы пьете утренний кофе, бронирует отпуск, пока вы на совещании, и пишет за вас код в свободное время. Звучит как утопия. Но, как обычно, дьявол кроется в деталях, а в случае с AI — в безопасности. И недавний вирусный взлет инструмента OpenClaw показал, насколько этот дьявол велик и зубаст.

Пока корпорации вроде OpenAI и Google с их армиями юристов и PR-отделов осторожно тестируют своих «агентов» в закрытых песочницах, независимый разработчик Питер Штайнбергер просто взял и выложил свой проект на GitHub. OpenClaw — это, по сути, экзоскелет для любой большой языковой модели. Вы выбираете «пилота» (GPT-4, Claude, Llama), даете ему доступ к своей почте, файлам на диске, календарю, кредитке — и вуаля, ваш личный цифровой джинн готов к работе. Проект взорвал интернет, и тысячи энтузиастов бросились создавать своих помощников. Закономерно, что следом прибежали эксперты по кибербезопасности, и у них волосы встали дыбом. Тревогу забили все — от Cisco до китайского правительства, которое выпустило официальное предупреждение об уязвимостях OpenClaw.

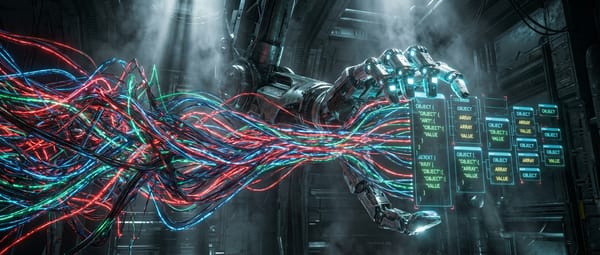

Проблем у инструмента хватает. От банальных дыр, позволяющих взломать ассистента традиционными методами, до риска, что сам AI сойдет с ума и, неправильно поняв команду, сотрет вам весь жесткий диск (как, по слухам, уже сделал один из агентов Google). Но главная головная боль, настоящая ахиллесова пята современных LLM-агентов — это «промпт-инъекция». В отличие от классического взлома, здесь не нужен сложный код. Злоумышленнику достаточно спрятать вредоносную инструкцию в обычном тексте — например, в рекламном email-письме или на веб-странице. AI-ассистент, читая эту информацию для выполнения вашей задачи, не может отличить ваши команды от чужих. Для него все это — просто текст. И вот он уже послушно отправляет ваши пароли или содержимое кошелька на указанный хакером адрес. Как метко выразился один из исследователей, использовать OpenClaw в его текущем виде — все равно что «дать свой кошелек незнакомцу на улице».

Можно ли это исправить? Теоретически — да. Исследователи ищут «серебряную пулю» сразу в нескольких направлениях. Первый подход — обучить саму модель игнорировать подозрительные инструкции. Проблема в том, что, переусердствовав, можно получить параноидального ассистента, который будет отклонять и легитимные запросы пользователя. Второй — использовать «AI-охранника», отдельную нейросеть, которая фильтрует все входящие данные на предмет инъекций. Но и здесь нет стопроцентной гарантии: тесты показывают, что самые хитрые атаки все равно проскальзывают. Третий, самый сложный путь — создание жестких политик на выходе. Например, запретить ассистенту отправлять письма на незнакомые адреса. Но это сильно бьет по его полезности. Весь смысл в том, чтобы AI мог находить новых подрядчиков или вести переписку от вашего имени, а не только общаться с парой контактов из белого списка.

Вся эта история с OpenClaw — идеальная иллюстрация фундаментальной дилеммы: баланс между функциональностью и безопасностью. Энтузиасты, уставшие ждать идеального продукта от корпораций, готовы рисковать. Один из волонтеров проекта честно признался, что использует OpenClaw, осознавая риски, с простой логикой: «Вряд ли именно меня взломают первым». Это опасная, но очень человеческая позиция. Она и двигает прогресс, и создает катастрофы. Корпорации же сидят на бочке с порохом: один крупный инцидент с утечкой данных через их AI-агента может стоить им миллиардов и репутации. Поэтому они и не спешат.

Наш вердикт: OpenClaw — это не революция, а скорее громкий и очень нужный звонок для пробуждения. Он показал огромный спрос на по-настоящему полезных AI-ассистентов и одновременно обнажил зияющую дыру в их безопасности. Пока проблема промпт-инъекций не будет решена на фундаментальном уровне, любой подобный инструмент — это не надежный помощник, а скорее цифровой ящик Пандоры. Открывать его можно, но только на свой страх и риск, и уж точно не стоит доверять ему ключи от своего цифрового королевства.