Apriel-H1 доказывает, что компактные модели могут мыслить не хуже гигантов

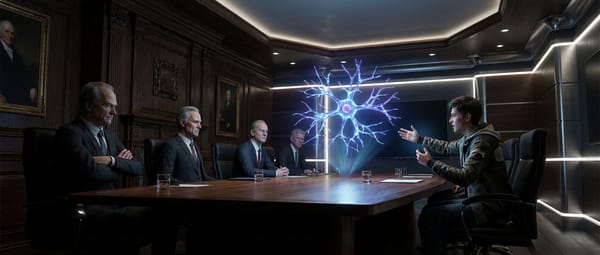

Мир искусственного интеллекта получил новое подтверждение того, что размер модели перестает быть решающим фактором качества. Релиз Apriel-H1 продемонстрировал неожиданно эффективный подход к дистилляции «рассуждающих» моделей (reasoning models). Вместо простого копирования ответов от крупных систем-учителей, новая архитектура фокусируется на передаче самой логики мышления. Это позволяет компактной нейросети демонстрировать результаты, сопоставимые с флагманскими решениями, потребляя при этом на порядки меньше вычислительных ресурсов.

Ключевым открытием, лежащим в основе Apriel-H1, стала методика отбора обучающих данных. Разработчики выяснили, что секрет успешной дистилляции кроется не в объеме датасета, а в специфической фильтрации цепочек рассуждений (Chain of Thought). Модель учится игнорировать «шумные» или избыточные шаги логики учителя, усваивая только критически важные узлы принятия решений. Такой подход открывает дорогу для запуска полноценных AI-агентов со сложной логикой непосредственно на устройствах пользователей, минуя облачные серверы компаний вроде OpenAI или Google.